Products

Products

SambaNova’s AI platform is the technology backbone for the next decade of AI innovation. Customers are turning to SambaNova to quickly deploy state-of-the-art AI and deep learning capabilities that help them outcompete their peers.

Products

The only, enterprise grade full stack platform, purpose built for generative AI

The platform for generative AI development and innovation

Technology

Technology

SambaNova delivers the only enterprise-grade full stack platform, from chips to models, purpose built for generative AI

Technology

The only, full stack platform purpose built for generative AI in the enterprise

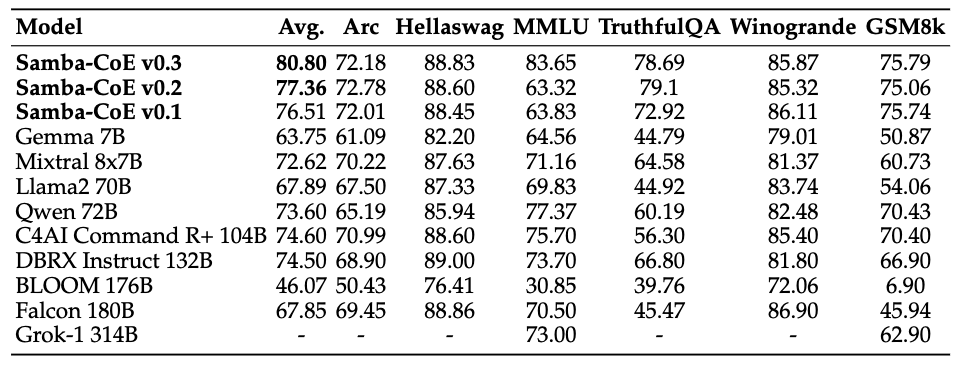

1T+ parameter models, that span business use cases with high accuracy

Resources

Find what you need to accelerate your AI journey.

Resource Categories

Technical Documentation

Solutions

Solutions

SambaNova delivers generative AI for the enterprise that can scale across use cases

Community

Community

Find the resources you need to create AI solutions

Model Curation

Community

Technical Documentation

About

About

WHO WE ARE

Customers are turning to SambaNova to quickly deploy state-of-the-art AI capabilities to gain competitive advantage. Our purpose-built enterprise-scale AI platform is the technology backbone for the next generation of AI computing. We power the foundation models that unlock the valuable business insights trapped in data.

FEATURED RESOURCE

-

ProductsSambaNova’s AI platform is the technology backbone for the next decade of AI innovation. Customers are turning to SambaNova to quickly deploy state-of-the-art AI and deep learning capabilities that help them outcompete their peers.The only, enterprise grade full stack platform, purpose built for generative AIThe platform for generative AI development and innovation

-

TechnologySambaNova delivers the only enterprise-grade full stack platform, from chips to models, purpose built for generative AIThe only, full stack platform purpose built for generative AI in the enterprise1T+ parameter models, that span business use cases with high accuracy

-

ResourcesFind what you need to accelerate your AI journey.Resource CategoriesTechnical Documentation

-

SolutionsSambaNova delivers generative AI for the enterprise that can scale across use casesFEATURED RESOURCE

-

CommunityFind the resources you need to create AI solutionsModel CurationCommunityTechnical Documentation

-

AboutWHO WE ARECustomers are turning to SambaNova to quickly deploy state-of-the-art AI capabilities to gain competitive advantage. Our purpose-built enterprise-scale AI platform is the technology backbone for the next generation of AI computing. We power the foundation models that unlock the valuable business insights trapped in data.FEATURED RESOURCE

- Support